本文聚焦于爬取各市疫情数据这一行为,深入探讨其背后所蕴含的技术故事,以及在数据爬取过程中所面临的重重挑战。

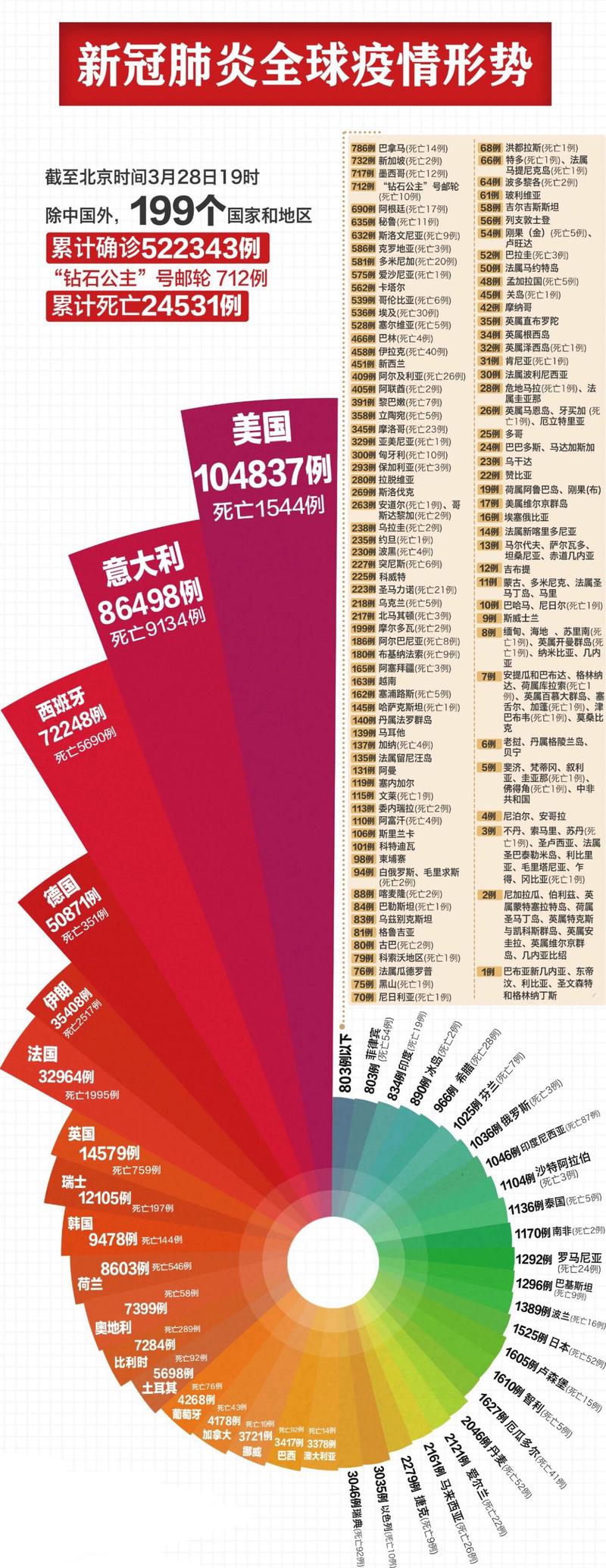

最近这段时间,疫情数据成了大家茶余饭后热议的话题,每天打开手机,看看自己所在城市的新增病例、治愈人数,心里多少能有个底,但你知道吗?这些看似简单的数据背后,其实有一群人在默默地用技术手段爬取、整理,再呈现给我们,咱们就来聊聊爬取各市疫情数据那些事儿。

爬取疫情数据,听起来挺高大上的,其实说白了,就是用程序去各个官方网站、社交媒体上“抓”数据,这些数据来源五花八门,有卫生健康委员会的官网,有各大新闻媒体的报道,还有社交媒体上的实时更新,爬虫程序就像是个不知疲倦的小蜜蜂,一刻不停地穿梭在这些网站之间,把有用的信息一点点收集起来。

爬取数据可不是件容易的事儿,你得知道去哪儿找数据,不同城市的疫情数据发布渠道可能都不一样,有的城市喜欢在官网上公布,有的则更倾向于通过社交媒体发布,这就需要爬虫开发者对各个城市的数据发布习惯有个大致的了解,才能有的放矢。

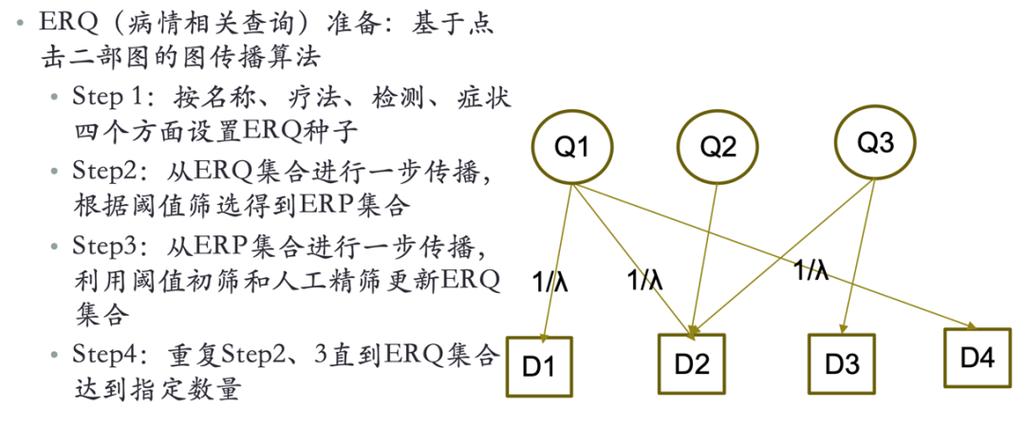

找到了数据源,接下来就是编写爬虫程序了,这个过程就像是在搭建一座桥梁,把数据源和我们的数据库连接起来,爬虫程序得能够识别网页上的数据结构,把有用的信息提取出来,再转换成我们需要的格式,这中间涉及到很多技术细节,比如如何处理网页的动态加载、如何绕过反爬虫机制等等。

举个例子吧,有些城市的疫情数据是通过JavaScript动态加载的,这就意味着传统的爬虫方法可能行不通,这时候,开发者就得使用一些更高级的技术,比如Selenium或者Puppeteer,来模拟浏览器的行为,从而获取到完整的数据。

爬取到数据之后,还得进行清洗和整理,因为不同来源的数据格式可能都不一样,有的可能是表格形式,有的则是纯文本,这就需要我们编写一些脚本,把这些杂乱无章的数据转换成统一的格式,方便后续的分析和展示。

爬取疫情数据也不是没有风险的,你得确保自己的爬虫程序不会给目标网站带来过大的负担,否则可能会被网站封禁IP,你还得注意数据的准确性和时效性,毕竟,疫情数据是关系到公众健康的大事,容不得半点马虎。

说到这里,你可能要问了,爬取这些疫情数据到底有什么用呢?用处可大了,通过分析这些数据,我们可以了解到各个城市的疫情发展趋势,为政府决策提供参考;也可以帮助公众更好地了解疫情动态,做好个人防护,对于科研人员来说,这些数据更是宝贵的研究资料。

爬取各市疫情数据是一项既充满挑战又极具意义的工作,它不仅考验着开发者的技术实力,更考验着他们的责任心和使命感,在这个特殊时期,让我们向那些默默付出、用技术守护公众健康的开发者们致敬吧!

还没有评论,来说两句吧...