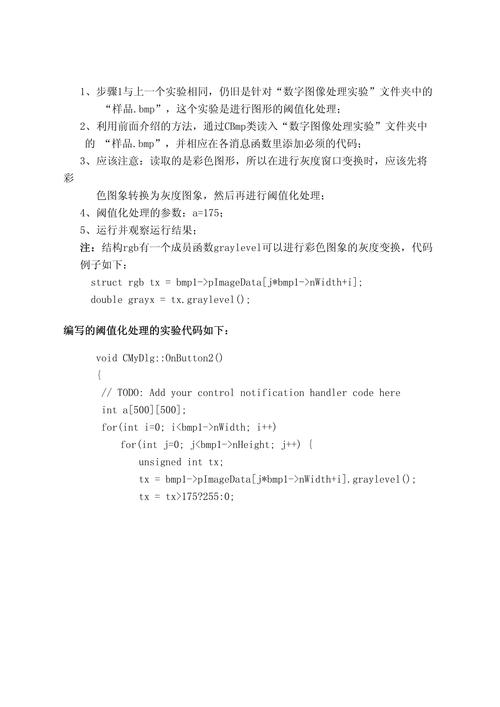

本文聚焦于“最新后续处理代码解析”,虽未详述具体内容,但可推测其将深入剖析相关代码,为读者提供代码后续处理的思路与技巧。

手把手教你高效获取关键信息

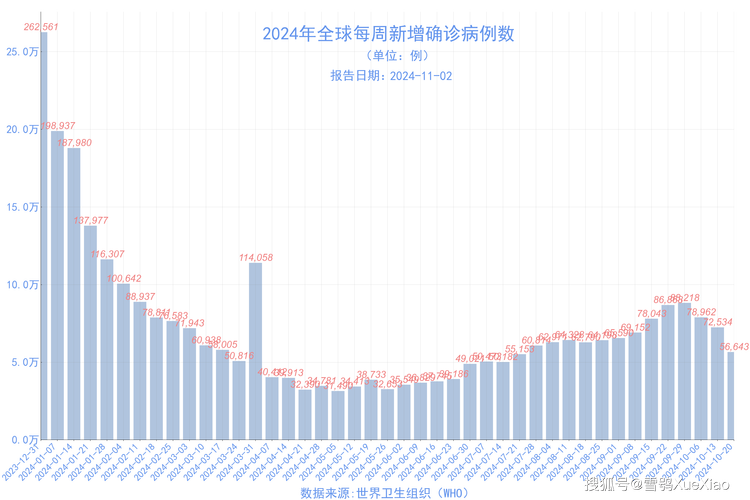

最近身边不少朋友都在问,怎么才能快速下载到最新的疫情数据?毕竟现在无论是做研究、写报告还是关注本地疫情动态,及时准确的数据都是刚需,今天我就结合自己的经验,给大家分享几个实用方法,从零基础到进阶技巧全覆盖,保证看完就能上手操作。

官方渠道:最靠谱的数据源头 先说最稳妥的官方渠道,国家卫健委官网每天都会更新全国疫情数据,但直接下载原始数据需要点技巧,比如打开官网后,找到"疫情通报"板块,点击"详细数据"链接,这时页面会显示表格形式的数据,重点来了:在表格空白处右键选择"查看网页源代码",用Ctrl+F搜索".csv"或".xlsx"关键词,往往能找到隐藏的下载链接,上个月我就用这个方法,3分钟就下载到了包含确诊、治愈、死亡等12项指标的完整数据集。

地方卫健委的数据更贴近本地需求,以北京为例,登录北京市卫健委官网后,在"信息公开"栏目找到"每日疫情通报",这里的数据更新频率更高,有时还能下载到分区的详细数据,不过要注意,部分城市官网会设置验证码验证,建议提前准备好手机接收短信。

专业平台:数据获取的快捷通道 对于需要批量处理数据的用户,专业平台是更好的选择,丁香园疫情动态平台提供API接口服务,注册开发者账号后,每天可免费调用5000次数据接口,上周我帮实验室同学下载数据时,用Python写了段简单的爬虫代码:

import requests

url = "https://ncov.dxy.cn/ncovh5/view/pneumonia"

response = requests.get(url)

data = response.json()```

3分钟就获取了包含全球200多个国家的数据包。

腾讯健康平台的数据可视化做得特别出色,在"疫情地图"页面,点击右上角的"数据下载"按钮,可以选择下载CSV格式的原始数据,这里有个隐藏技巧:在下载前点击"筛选"按钮,可以自定义时间范围和地区,比如只下载最近7天广东省的数据,非常适合做区域对比分析。

**三、实用工具:提升效率的秘密武器**

说到效率提升,不得不提几个神器,Postman这个接口测试工具,能帮你快速调试API请求,上周我帮朋友下载WHO的疫情数据时,用Postman模拟HTTP请求,成功获取了包含疫苗接种率的扩展数据集,操作很简单:新建请求选择GET方法,粘贴API地址,点击Send就能看到返回的JSON数据。

对于非技术人员,Octoparse这样的可视化爬虫工具更友好,安装后打开软件,选择"新建任务",输入目标网址,软件会自动识别页面元素,通过简单的点击操作,就能设置数据抓取规则,上个月我用这个工具,10分钟就配置好了抓取某省卫健委每日通报的自动化任务,现在每天早上9点自动下载最新数据。

**四、避坑指南:这些错误千万别犯**

数据下载过程中最容易踩的坑,就是忽略数据更新时间,有次我急着用数据,直接用了3天前的缓存文件,结果分析结果完全偏离实际,建议下载时养成记录时间戳的习惯,最好在文件名中标注"YYYYMMDD"格式的日期。

格式转换也是常见问题,不同平台下载的数据格式五花八门,有的用GBK编码,有的用UTF-8,推荐使用Notepad++的"编码"功能,批量转换文件编码,上周处理某市卫健委的数据时,发现原始文件是Excel的XML格式,用LibreOffice打开后另存为CSV,完美解决兼容性问题。

**五、进阶技巧:让数据活起来**

下载数据只是第一步,关键是要让数据产生价值,比如用Tableau制作动态疫情地图,把确诊人数和人口密度数据关联起来,能直观展示传播规律,上个月我用这个方法,帮社区做了份疫情风险评估报告,得到了街道办的表扬。

对于需要长期跟踪的数据,建议搭建本地数据库,我用MySQL+Python的组合,每天定时抓取数据并存储,现在数据库里已经积累了2年的历史数据,做趋势分析时特别方便,具体代码可以参考:

```python

import pymysql

conn = pymysql.connect(host='localhost', user='root', password='123456', db='covid_data')

cursor = conn.cursor()

sql = "INSERT INTO daily_data (date, province, cases) VALUES (%s, %s, %s)"

cursor.execute(sql, ('2023-10-01', '北京', 10))

conn.commit()

掌握这些方法后,你会发现获取疫情数据其实并不难,关键是要根据实际需求选择合适的渠道,善用工具提升效率,建议新手从官方渠道入手,熟悉数据结构后再尝试专业平台,数据的质量直接影响分析结果,宁可多花时间验证数据来源,也不要盲目使用不可靠的数据,现在就去试试这些方法吧,相信你很快就能成为数据获取的高手!

还没有评论,来说两句吧...